Analysis of "SaySelf: Teaching LLMs to Express Confidence with Self-Reflective Rationales"

This paper introduces SaySelf, a novel …

解密 Llama:探秘大型语言模型的训练之道 - 损失函数篇

大型语言模型 (LLM) 如 Llama,凭借其强大…

Llama 训练过程中,如何制定 损失函数

在训练语言模型 (如 LLaMA) 时,损失函数 (…

美国经济警钟敲响:消费者支出放缓,降息预期升温?

近期,美国经济数据释放出令人担忧的信号…

自我精炼:让语言模型更懂你

引言 在人工智能的世界里,语言模型 (LLMs…

代码预训练:提升语言模型实体追踪能力的新途径

引言:语言模型的新突破 在人工智能领域,…

100 开头的 IP 地址:是公网还是内网?

你是否留意过自家路由器的 WAN 口 IP 地址?最…

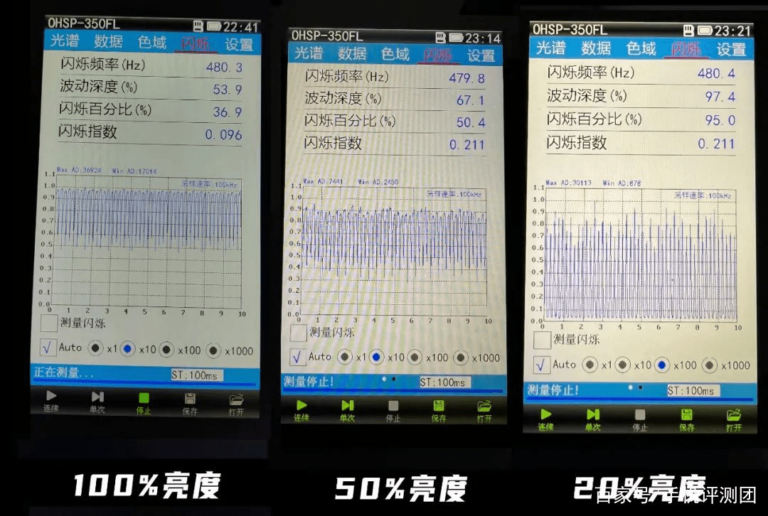

OLED 屏幕频闪:揭开真相的科普

随着智能手机的普及和使用时间的增加,人…

OLED 屏幕的频闪问题:真相揭秘

随着智能手机的普及和使用时间的增加,人…

SSE (Server-Sent Events) 概念和工作原理

一、什么是 SSE? Server-Sent Events (SS…

苹果公司近期开发了一种名为 ReALM(Reference Resolution As Language Modeling) 的系统

苹果公司最近在人工智能领域取得了新的研…