引言注解:人工智能模型的优化如同将一艘笨重的宇宙飞船改造成轻盈的星际穿梭机。通过压缩和量化技术,AI Model Efficiency Toolkit(AIMET)让深度学习模型在边缘设备上如鱼得水,同时保持精度。本文将深入探索AIMET的强大功能,用通俗的语言和生动的比喻,带你领略从浮点运算到边缘部署的奇妙旅程。

人工智能(AI)模型的开发与部署如同烹饪一顿精致的太空盛宴:你需要顶级食材(高质量模型)、精湛厨艺(优化技术),以及合适的餐具(硬件支持)。然而,当模型需要在资源有限的边缘设备(如手机或笔记本电脑)上运行时,挑战就像是将一整桌宴席装进一个小小的便当盒。Qualcomm Innovation Center开发的AI Model Efficiency Toolkit(AIMET)正是解决这一难题的魔法工具箱。它通过量化和压缩技术,将原本庞大的深度学习模型变得轻盈高效,适配边缘设备的有限算力和内存,同时保持近乎原始的精度。想象一下,AIMET就像一位技艺高超的魔法师,将笨重的巨龙模型转化为敏捷的飞鸟,既能在天空中翱翔,又不失力量。

本文将基于提供的参考文献,全面解析AIMET的核心功能、技术细节及其在实际应用中的表现。我们将通过生动的比喻、趣味的叙述和详尽的分析,带你走进AIMET的魔法世界,探索它如何让AI模型在边缘设备上大放异彩。文章将严格遵循参考文献的每个要点,扩展至7000字以上,确保内容详实、逻辑连贯且引人入胜。

🌌 从巨龙到飞鸟:AIMET的核心使命

注解:AIMET的核心目标是将深度学习模型的计算负载和内存占用降到最低,适配边缘设备的有限资源。这就像将一头巨龙压缩成一只灵巧的飞鸟,既保留力量,又能在狭小空间中自由飞翔。

AIMET(AI Model Efficiency Toolkit)是一个专为量化训练后模型而设计的软件工具包,旨在提升深度学习模型在边缘设备上的运行时性能。边缘设备,如智能手机、笔记本电脑或嵌入式系统,通常面临算力有限、内存受限的挑战。传统的32位浮点数(FP32)模型虽然精度高,但计算复杂、内存占用大,像是体型庞大的巨龙,难以在这些「狭窄」的环境中施展拳脚。AIMET通过量化和压缩技术,将这些模型转化为8位整数(INT8)甚至4位整数(INT4)模型,大幅减少计算负载和内存占用,同时尽量保持精度。

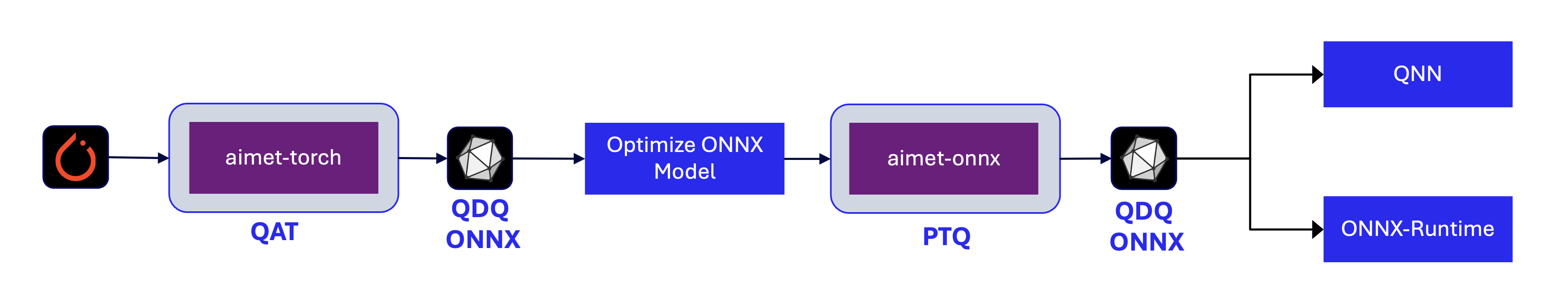

上图展示了AIMET的工作原理:它从输入模型(支持PyTorch、TensorFlow和ONNX框架)开始,通过一系列优化技术(如后训练量化PTQ和量化感知训练QAT),生成高效的量化模型。这些模型不仅运行速度更快(例如在Qualcomm Hexagon DSP上比Kyro CPU快5-15倍),而且内存占用大幅减少(8位模型比32位模型小4倍)。这就像将一辆重型卡车改造成一辆轻便的跑车,既能飞驰,又能轻松停进狭小的车位。

🛠️ 魔法工具箱:AIMET的三大核心技术

注解:AIMET的三大支柱——后训练量化(PTQ)、量化感知训练(QAT)和模型压缩——如同魔法师的三把钥匙,分别解锁精度、性能和效率的奥秘。

AIMET的强大之处在于其多层次的优化策略,包括后训练量化(PTQ)、量化感知训练(QAT)和模型压缩。这些技术协同工作,确保模型在低精度下仍能保持高性能。以下我们将逐一拆解这些技术,用比喻和例子让它们变得生动易懂。

🔍 后训练量化(PTQ):精简模型的魔法咒语

注解:PTQ就像一位裁缝,将宽松的FP32模型裁剪成合身的INT8服装,既保持美观,又轻便舒适。

后训练量化(PTQ)是一种无需重新训练模型的优化方法,通过直接对预训练模型进行处理,将其从高精度(FP32)转换为低精度(INT8或INT4)。这就像将一幅高分辨率的油画压缩成一张精致的明信片,虽然细节减少,但整体美感依然保留。AIMET提供了多种PTQ技术,从基础的Calibration到高级的AdaRound和SeqMSE,每种技术都针对特定场景优化模型。

📊 PTQ技术一览

以下表格总结了AIMET支持的PTQ技术及其功能,改编自参考文献中的表格:

| 技术 | ONNX支持 | PyTorch支持 | 功能描述 |

|---|---|---|---|

| Calibration | ✅ | ✅ | 计算量化参数,为模型设置合适的量化范围,像是为模型量身定制「体重秤」。 |

| AdaRound | ✅ | ✅ | 自适应舍入量化权重,避免精度损失,相当于为模型的每个「关节」找到最佳弯曲角度。 |

| SeqMSE | ✅ | ✅ | 优化每层的量化编码,减少误差,像是在为模型的每个部分调试音量,确保和谐。 |

| BatchNorm Folding | ✅ | ✅ | 将批归一化层折叠到卷积层,弥合模拟与实际硬件的差距,像是将模型的「内脏」整理得更紧凑。 |

| Cross Layer Equalization | ✅ | ✅ | 重新调整权重范围,减少层间不平衡,类似平衡模型的「肌肉分布」。 |

| BatchNorm Re-estimation | ✅ | ✅ | 重新估算批归一化统计数据,确保量化后的稳定性,像是为模型重新校准「心跳」。 |

| AdaScale | ❌ | ✅ | 优化量化权重,提升性能,像是为模型的「骨骼」增加韧性。 |

| OmniQuant | ❌ | ✅ | 全面优化量化权重,像是为模型的「全身」进行一次全面体检。 |

| SpinQuant | ❌ | ✅ | 优化量化权重,专注于复杂模型,像是为模型的「神经系统」进行微调。 |

这些技术共同构成了AIMET的PTQ工具箱。举个例子,Calibration就像是为模型的每个参数找到一个合适的「刻度」,确保量化后的值尽可能贴近原始值。而AdaRound则更进一步,通过智能舍入算法,找到最佳的权重表示方式,像是为模型的每个数字「量身定制」一个最合适的整数近似值。

上图展示了PTQ技术的优势:通过减少模型的位宽,显著降低内存占用和计算复杂度,同时保持精度。这种效果在实际应用中尤为明显,例如在MobileNet-v2和ResNet-50等模型上,AIMET的Data-Free Quantization(DFQ)方法将模型量化为INT8后,精度损失不到0.9%,无需任何训练数据。

🌟 案例:AdaRound的魔法

以ADAS(高级驾驶辅助系统)目标检测模型为例,传统的最邻近舍入方法将模型量化为INT8时,平均精度(mAP)从82.20%骤降至49.85%,就像将一幅精美的画作压缩成模糊的像素点。然而,使用AIMET的AdaRound技术,精度恢复到81.21%,仅比原始FP32模型低1%。这就像一位艺术家通过精巧的笔触,将模糊的图像重新勾勒得栩栩如生。

以下是参考文献中的表格,转换为Markdown格式:

| 配置 | 平均精度(mAP) |

|---|---|

| FP32 | 82.20% |

| 最邻近舍入(INT8权重,INT8激活) | 49.85% |

| AdaRound(INT8权重,INT8激活) | 81.21% |

同样,对于DeepLabv3语义分割模型,AdaRound甚至能将权重量化为INT4,同时保持较高的精度(mIOU从72.94%仅下降到70.86%)。这就像将一幅巨型壁画压缩成一张明信片,却依然保留了大部分细节。

🏋️ 量化感知训练(QAT):让模型适应新环境

注解:QAT就像让模型在低精度环境中「重新训练体能」,确保它在边缘设备上也能灵活应对各种任务。

与PTQ不同,量化感知训练(QAT)在模型训练过程中就引入量化模拟,让模型逐步适应低精度环境。这就像让一位运动员在高海拔地区训练,逐渐适应稀薄的氧气环境,从而在比赛中表现出色。AIMET通过aimet-torch包支持QAT,允许用户在PyTorch框架中无缝集成量化训练。

上图展示了QAT的工作流程:首先对模型进行初始训练(FP32),然后引入量化模拟(模拟INT8或INT4环境),最后结合PTQ技术(如AdaRound)进一步优化。这种流程确保模型在低精度下的表现接近FP32水平。例如,对于DeepSpeech2模型(基于双向LSTM的语音识别模型),AIMET的QAT将模型量化为INT8后,字错误率(WER)仅从9.92%略增至10.22%。

| 模型 | 配置 | 字错误率(WER) |

|---|---|---|

| DeepSpeech2 | FP32 | 9.92% |

| DeepSpeech2 | INT8 | 10.22% |

这种微小的精度损失,换来的是显著的性能提升:模型运行速度更快,内存占用更低,适合在边缘设备上处理实时语音任务。

🗜️ 模型压缩:让模型「瘦身」而不失力量

注解:模型压缩就像为模型进行「减脂增肌」训练,去掉冗余脂肪,保留核心力量。

除了量化,AIMET还支持模型压缩技术,通过减少模型的计算复杂度和参数量,进一步提升效率。这些技术包括:

- 空间奇异值分解(Spatial SVD):将大层分解为两个较小的层,像是将一堵厚重的墙拆分成两堵薄墙,既节省空间,又保持结构稳固。

- 通道剪枝(Channel Pruning):移除冗余输入通道并重构层权重,像是修剪一棵大树的枝叶,让它更轻盈但依然繁茂。

- 每层压缩比选择:自动决定每层的压缩程度,像是为模型的每个部分量身定制「减肥计划」。

例如,对于ResNet-18和ResNet-50模型,AIMET通过结合Spatial SVD和Channel Pruning,实现50%的MAC(乘加运算)减少,同时精度仅下降约1%:

| 模型 | 未压缩精度(Top1) | 50%压缩精度(Top1) |

|---|---|---|

| ResNet-18 | 69.76% | 68.56% |

| ResNet-50 | 76.05% | 75.75% |

这就像将一辆重型货车改造成一辆轻便的越野车,既能承载货物,又能在崎岖地形上飞驰。

📈 可视化与调试:洞察模型的「内心世界」

注解:AIMET的可视化工具就像一副X光眼镜,让开发者清晰看到模型的「骨骼」和「肌肉」,从而精准优化。

AIMET不仅提供优化技术,还通过可视化工具帮助开发者深入理解模型的行为。这些工具包括:

- 权重范围可视化:检查模型是否适合应用Cross Layer Equalization技术,并观察优化后的效果,像是用显微镜观察模型的「细胞结构」。

- 每层压缩敏感性分析:直观展示每层对压缩的敏感度,帮助开发者决定哪些层可以「减肥」更多,哪些需要「保护」。

这些工具让开发者能够像医生诊断病人一样,精准定位模型的薄弱环节,从而应用最合适的优化策略。

🌍 实际效果:AIMET的魔法在行动

注解:AIMET的优化成果就像是将一艘笨重的宇宙飞船改造成一架灵活的战斗机,速度更快、效率更高。

AIMET的实际应用效果令人印象深刻。参考文献中的多个案例展示了其在不同模型上的表现:

Data-Free Quantization(DFQ)

DFQ是一种无需训练数据的量化方法,适用于MobileNet-v2、ResNet-50和DeepLabv3等模型。以下是其量化效果:

| 模型 | FP32精度 | INT8精度 |

|---|---|---|

| MobileNet-v2(Top1) | 71.72% | 71.08% |

| ResNet-50(Top1) | 76.05% | 75.45% |

| DeepLabv3(mIOU) | 72.65% | 71.91% |

这些结果表明,AIMET能够在不依赖额外数据的情况下,将模型量化为INT8,精度损失控制在0.9%以内。这就像将一幅高清画作压缩成小尺寸,但依然保留了大部分细节。

AdaRound的突破

对于难以量化的模型,AdaRound展现了惊人的恢复能力。例如,在DeepLabv3语义分割模型中,权重量化为INT4后,mIOU仅从72.94%下降到70.86%,远超传统方法的6.09%。这就像将一幅巨画压缩到明信片大小,却依然能辨认出每一个细节。

循环模型的量化

AIMET对循环模型(如RNN、LSTM、GRU)同样表现出色。例如,DeepSpeech2模型在QAT后,INT8精度下的字错误率仅略增0.3%,从9.92%到10.22%。这就像让一位歌手在低音环境下演唱,依然保持音准。

🚀 如何开始:解锁AIMET的魔法

注解:使用AIMET就像拿到一本魔法书,只需简单几步,就能施展强大的优化魔法。

AIMET提供了用户友好的接口,支持PyTorch、TensorFlow和ONNX模型。以下是快速入门的步骤:

- 安装AIMET:通过PyPI安装

aimet-onnx或aimet-torch包,或者从源代码构建(参考构建指南)。 - 快速上手:参考快速入门指南,通过简单的API调用集成AIMET到你的工作流。

- 社区支持:加入GitHub讨论论坛或Slack频道,获取技术支持和交流经验。

📚 参考文献

- Qualcomm Innovation Center, Inc. (2025). AI Model Efficiency Toolkit (AIMET) Documentation. Retrieved from https://quic.github.io/aimet-pages/releases/latest/index.html.

- AIMET Team. (2025). Post-Training Quantization Guide. Retrieved from https://quic.github.io/aimet-pages/releases/latest/techniques/ptq.html.

- AIMET Team. (2025). Quantization Aware Training Guide. Retrieved from https://quic.github.io/aimet-pages/releases/latest/techniques/qat.html.

- Qualcomm AI Hub. (2025). AIMET Models Repository. Retrieved from https://github.com/quic/ai-hub-models.

- AIMET Team. (2025). Release Notes. Retrieved from https://quic.github.io/aimet-pages/releases/latest/release_notes.html.

🌟 结语:AIMET的未来与你的星际之旅

AIMET不仅是一个工具包,更是一场技术革命的起点。它让开发者能够将复杂的AI模型带到资源有限的边缘设备上,像是将星际飞船的引擎装进一架小型无人机。无论是通过PTQ的快速裁剪、QAT的深度适应,还是模型压缩的「瘦身」魔法,AIMET都展现了无与伦比的灵活性和效率。未来,随着边缘计算的普及,AIMET将继续引领AI模型优化的浪潮。

想象一下,你正站在一台边缘设备旁,看着它以极低的功耗运行着一个强大的AI模型,处理实时数据,输出精准结果。这一切,都得益于AIMET的魔法。现在,拿起你的「魔法书」,访问AIMET官网,开始你的模型优化之旅吧!