房价的时空魔法:为什么短线像坐过山车,中线像谈恋爱,长线像养孩子?

一座城市的房价,就像一个活生生的巨型生物,它的心跳 (短期) 、呼吸 (中期) 和骨骼生长 (长期) 分别由三种完全不同的 ... 阅读更多

辫子下的铁链:满清王朝如何用两百七十年的时间,把一个文明重新拖回奴隶社会

🩸 开场白:这不是改朝换代,这是文明等级倒退 1644 年,李自成攻进北京,崇祯皇帝在煤山上吊自杀的那一刻,中国 ... 阅读更多

🏯 从 「任人唯亲」 到 「恶龙循环」:一部写给所有职场人的权力真人秀

那一年,李鸿章在 《走向共和》 里把一句大白话甩到所有人脸上: 「不任人唯亲,还要让我任人唯疏不成?」 少年时的我 ... 阅读更多

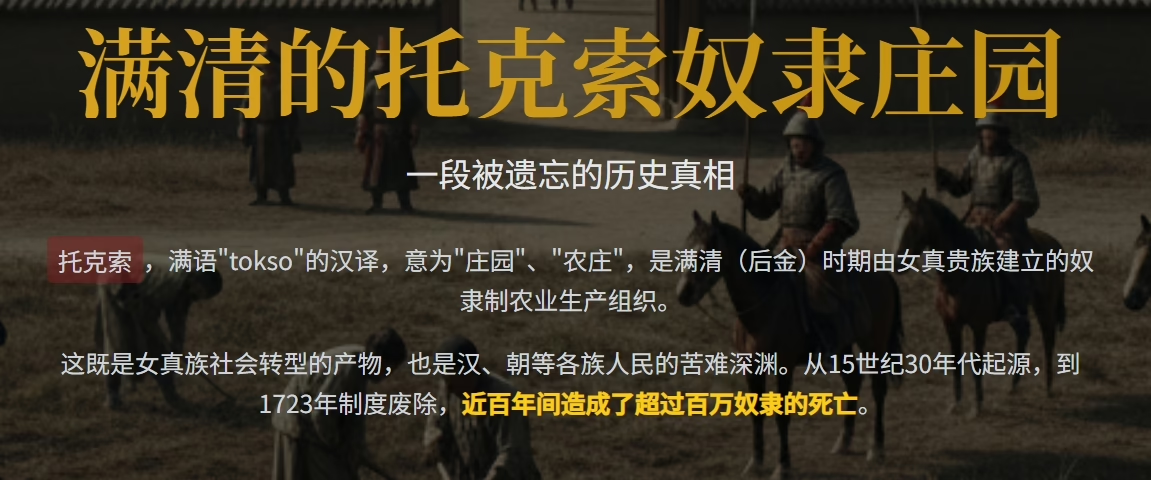

🌌被遗忘的铁链:满清托克索与人市,如何把一个文明古国拖进奴隶庄园的深渊

想象一下,你祖祖辈辈耕耘的田地,突然被一群骑马的旗人一圈就圈走;你全家瞬间变成无家可归的流民;为了活下去,你只 ... 阅读更多