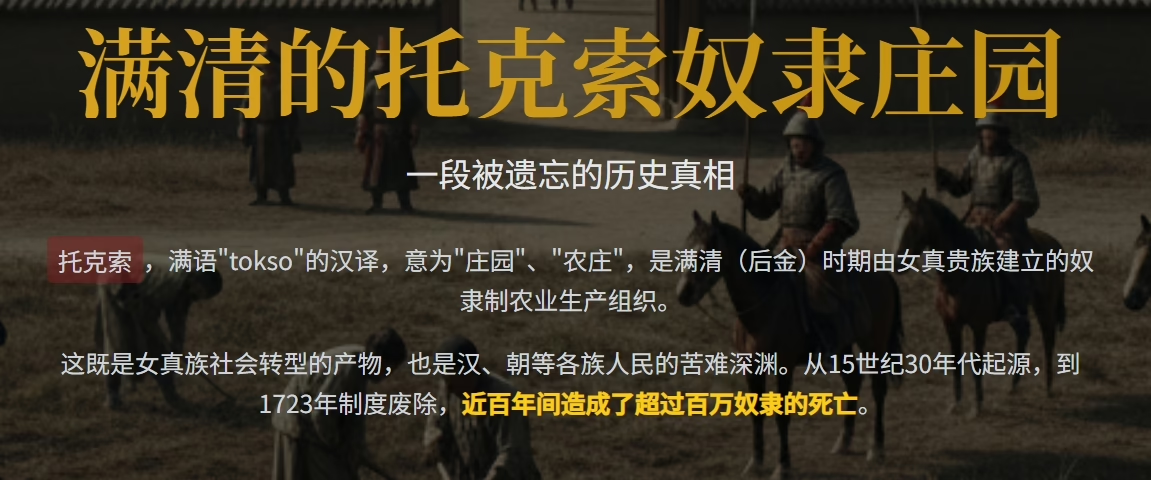

🌌被遗忘的铁链:满清托克索与人市,如何把一个文明古国拖进奴隶庄园的深渊

想象一下,你祖祖辈辈耕耘的田地,突然被一群骑马的旗人一圈就圈走;你全家瞬间变成无家可归的流民;为了活下去,你只 ... 阅读更多

中储房来了:一个老房改人如何用 「粮食思维」 拯救 7 亿平米库存

🌾 从粮食到房子:为什么 「住」 也该有国家粮仓? 想象一下,你家祖上在古代是管粮仓的官员。丰年的时候,国家低价大 ... 阅读更多

帝国皮肤下的千年鬼手:他们如何一次次换皮,把大一统玩成自己的长生游戏?

🧙♂️ 引子:历史书里藏着的 「他们」 到底是谁?想象一下,你正坐在故宫太和殿的龙椅上,冰冷的金砖提醒你:这把椅 ... 阅读更多

🌹鲜花盛开的镣铐:哈耶克 〈通往奴役之路〉 在 21 世纪的裂缝与回响

🔥 物化的幽灵:为什么哈耶克只看见了计划经济,却看不见资源饥饿? 想象一下,你正站在 1930 年代的伦敦街头,空 ... 阅读更多