在人工智能领域,追求建立一个具备人类级智能的代理一直是学术界的宏伟愿景。随着大型语言模型(Large Language Models, LLM)的出现,我们在多个任务上看到了其强大的解决能力。然而,绝大多数基于LLM的代理仍然依赖于手工设计的提示与策略,使其在动态和复杂的环境中显得力不从心。本文将深入探讨一种新型代理——Agent-Pro,它通过策略级反射与优化来实现自我学习和进化,展现了在复杂环境中更为理性的决策能力。

🤖 非人类级智能体的困境

尽管LLM在各种任务中表现优异,但大多数基于法学硕士的代理仍是为特定任务设计的复杂提示工程,使其在处理动态场景时显得笨拙。例如,在信息不完全的多人博弈中,代理无法从交互中学习或调整策略,这与人类通过经验不断优化决策的能力形成鲜明对比。为此,如何让代理具备类似人类的学习与适应能力,成为了一个重要的研究课题。

🧩 Agent-Pro的构建理念

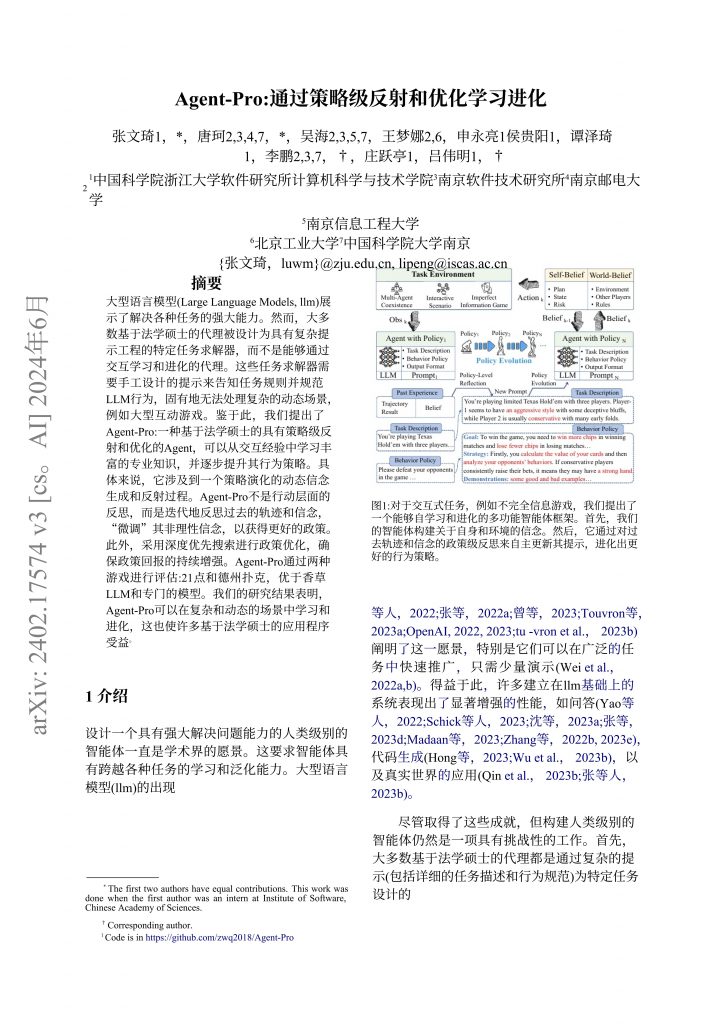

Agent-Pro的核心理念是通过动态信念生成与策略反思来进行自我优化。与传统的代理不同,Agent-Pro不仅在行动层面进行反思,还在策略层面上进行反思。其工作机制可以简单地描述为:在观察到环境信息后,Agent-Pro首先更新自身的信念,然后通过对过去轨迹的反思和优化,生成新的决策策略。

如图1所示,Agent-Pro根据自身与环境的信息构建信念,并通过对信念的反思不断调整行为策略。这一过程使其能够适应复杂动态场景,例如多人德州扑克和21点等游戏。

🌀 策略级反思与优化

Agent-Pro的创新之处在于其引入了策略级反思机制。这个机制允许代理对其过去的决策进行深度分析,而不是仅仅关注单一的行动。例如,在德州扑克中,Agent-Pro在每一轮结束后会反思其信念的合理性,并总结出行为准则和世界建模,以便在未来的对局中做出更为理性的选择。

在这一过程中,Agent-Pro不仅记录下对手的游戏风格,还对每个对手的行动进行分析,从而形成更加精准的信念模型。通过这种方式,它能够在复杂的博弈中不断提升自身的决策能力。

🎲 案例研究:21点与德州扑克

为了验证Agent-Pro的有效性,研究者们在21点与德州扑克这两款游戏中进行了大量实验。在这些实验中,Agent-Pro通过自我学习与反思,在与其他基线模型的对抗中表现出了显著的优势。

例如,在21点的比赛中,Agent-Pro的决策不仅更加理性,且在分析庄家手牌与自身手牌时,展现出了更强的风险评估能力。与传统的基线模型相比,Agent-Pro能够在更少的失误中,获得更高的胜率。

同样,在德州扑克的实验中,Agent-Pro通过对手的行为进行分析,能够在适当的时候虚张声势,施压对手,最终赢得比赛。这种能力的背后是其不断优化的信念模型和决策策略。

🔍 反思与未来展望

尽管Agent-Pro在多个实验中表现出色,但我们也必须认识到其局限性。首先,Agent-Pro的学习过程依赖于其基础模型的能力,特别是在推理与反思方面。此外,在与最先进的强化学习算法(如CFR plus)的比较中,Agent-Pro仍有提升的空间。

未来的研究可以进一步优化Agent-Pro,使其不仅在游戏场景中表现优异,还能适应更广泛的复杂任务。通过引入更多的环境动态与对手策略,Agent-Pro有望成为一个更加智能的自我学习代理,推动人工智能的进一步发展。

📚 参考文献

- Zhang, W. , et al. (2024). Agent-Pro:通过策略级反射和优化学习进化. arXiv:2402.17574.✅

- Shinn, N. , et al. (2023). Reflexion: an autonomous agent with dynamic memory and self-reflection. ArXiv.✅

- Mnih, V. , et al. (2015). Human-level control through deep reinforcement learning. Nature.✅

- Wei, J. , et al. (2022). Emergent abilities of large language models. CoRR.✅

- Touvron, H. , et al. (2023). Llama: Open and Efficient Foundation Language Models. ArXiv.✅

本文通过分析Agent-Pro的设计与实施,探讨了智能体在动态环境中如何通过策略级反思与优化学习进化,为构建更智能的人工智能代理提供了新的思路与方向。